Google正式整合Kubernetes引擎与GPU服务

近日Google云端服务加强许多深度学习、机器学习应用相关的功能,先是扩充虚拟主机硬体规格,推出主打大记忆体容量的ultramem规格VM,让使用者能进行高效能运算,同时,公有云平台的先占式GPU、TPU也在近日陆续上线,企业可以花费比随需服务更便宜的价格,使用GPU、TPU资源。而这一次Google则是宣布,公有云GPU服务现在正式与Kubernetes引擎(GKE)整合。

目前GCP旗下的GPU硬体共有3种选择,从价格较入门等级的K80,至中阶P100及高阶V100,让使用者可以按需选择。想要使用新功能的使用者,现在Google也有提供300美元免费试用额度。

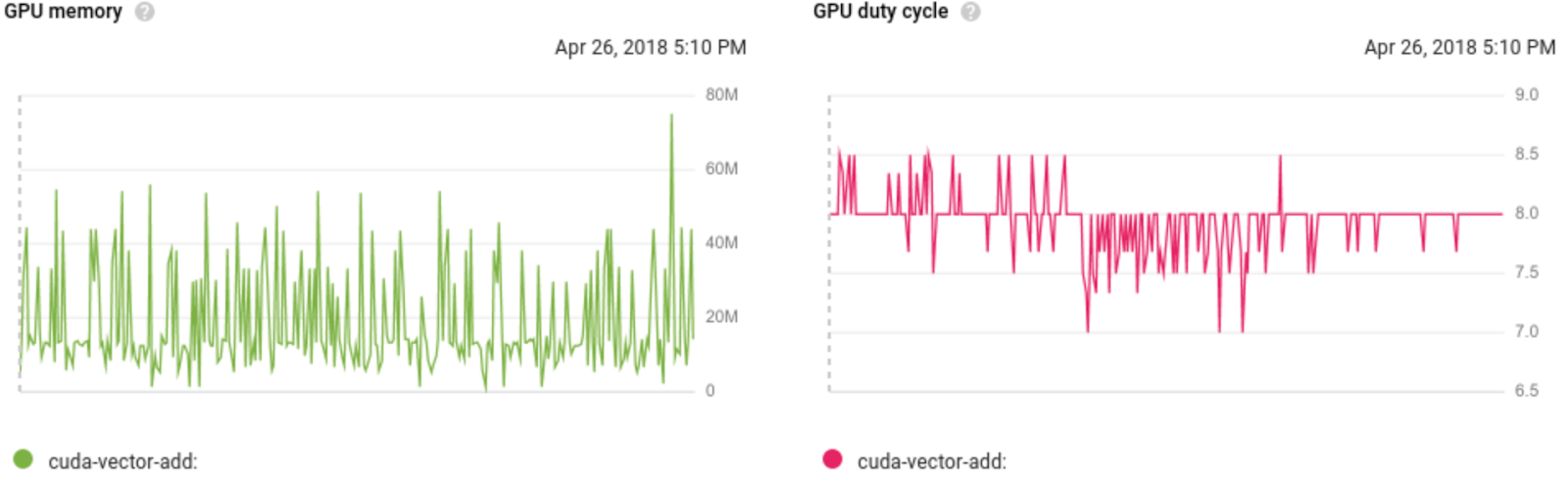

这次发布后,企业在GKE环境中运作的容器应用程式,便可以搭配GPU服务,执行CUDA工作负载,「可以借力GPU大量处理能力,同时免去管理VM的工作」,Google表示,此服务也可以搭配日前正式上线的先占式GPU服务使用,降低企业进行机器学习运算的成本。现在此功能,也已经和Google云端监控服务Stackdriver整合,使用者可以观察,现在GPU资源的存取频率、GPU资源的可用量,或者GPU的配置状况。

此外,在Kubernetes环境中使用GPU服务的企业,也可以一併使用Google Kubernetes引擎的一些现有功能。像是搭配Node资源池功能,让现有Kubernetes丛集上的应用程式可以存取GPU资源。当企业应用规模弹性改变时,则可以选用丛集扩充功能,系统可以自动扩充内建GPU的节点,当基础架构中没有任何Pod需要存取GPU资源时,系统就会自动关闭这些扩充节点,GKE也会确保节点上的Pod,都是需要存取GPU资源的Pod,避免没有GPU需求的Pod被部署至这些节点运作。而系统管理员可以利用资源配额功能,当多个团队共用大规模丛集时,限制各使用者能存取的GPU资源。

现在此功能,也已经和Google云端监控服务Stackdriver整合,使用者可以观察,现在GPU资源的存取频率、GPU资源的可用量,或者GPU的配置状况。图片来源:Google

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

【京东实名认证怎么解绑】在使用京东购物时,很多用户会进行实名认证以确保账户安全和交易顺利。但随着时间的...浏览全文>>

-

【云南有什么大学】云南省作为中国西南地区的重要省份,拥有众多高等院校,涵盖了综合性大学、理工类院校、师...浏览全文>>

-

【云南有什么茶叶比较出名的】云南是中国著名的茶产区之一,拥有丰富的茶文化与多样的茶品种。由于独特的地理...浏览全文>>

-

【云南有哪些茶叶品种】云南是中国茶叶的重要产地之一,以其丰富的茶树资源和多样的茶叶品种而闻名。云南的气...浏览全文>>

-

【京东实名认证有什么影响】在京东平台购物或进行相关操作时,用户常常会遇到“实名认证”的要求。实名认证不...浏览全文>>

-

【云南有名的特产是什么】云南,地处中国西南边陲,是一个多民族聚居的省份,拥有丰富的自然资源和独特的民族...浏览全文>>

-

【云南鹰嘴桃什么时间成熟呢】云南鹰嘴桃,因其果形独特、口感鲜美而受到许多消费者的喜爱。它不仅味道清甜多...浏览全文>>

-

【云南彝族阿诗玛传说】一、“云南彝族阿诗玛传说”是云南省彝族地区流传已久的一则民间故事,具有深厚的文化...浏览全文>>

-

【云南野当归介绍】云南野当归,学名Angelica polymorpha,是伞形科当归属的一种野生植物,主要分布于中国西...浏览全文>>

-

【云南洋芋焖饭的做法】云南洋芋焖饭是一道具有地方特色的家常美食,以土豆(洋芋)为主料,搭配米饭、肉类或...浏览全文>>