Nvidia发表超大规模推理平台瞄準大规模AI推理应用需求

Nvidia推出用于语音、影片、图片以及推荐服务的TensorRT超大规模推理平台(TensorRT Hyperscale Inference Platform),其使用的Tesla GPU提供高速处理深度学习工作负载的能力,而推理最佳化引擎TensorRT则可以充分利用Tesla GPU的效能,处理影片串流、语音和推荐系统等应用,并为Nvidia DeepStream SDK提供运算基础。

Nvidia提到,现在大规模资料中心可以借助超大规模推理平台的能力,使用增强的自然语言互动,并直接获取查询的答案,而非只是一些预存的可能候选答案。

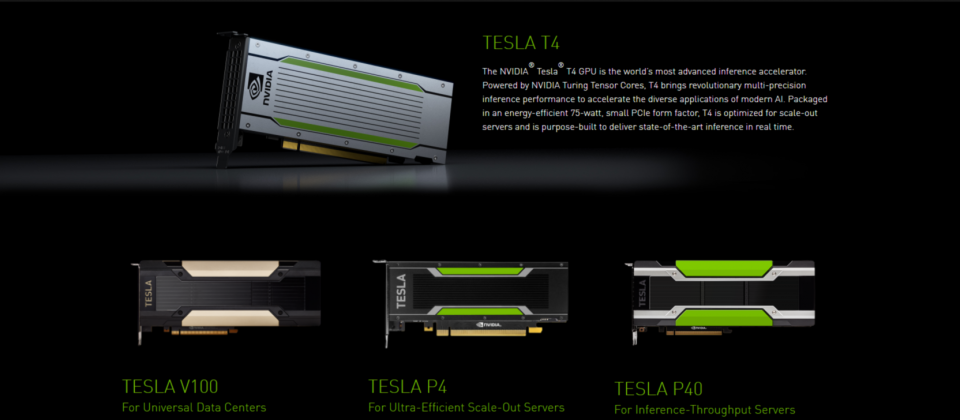

超大规模推理平台由三个主要部分组成,Tesla T4 GPU、TensorRT 5以及TensorRT推理伺服器。Tesla T4 GPU拥有320个Turing Tensor Cores以及2,560个CUDA核心,提供灵活的FP32、FP16、INT8和INT4的多精度运算,其推测速度是相同耗能CPU的40倍。

而TensorRT 5则是推理最佳化程式和Runtime引擎,TensorRT 5支援Turing Tensor Core,针对多精度工作负载扩展了神经网路最佳化,能低延迟提供推荐系统、语音辨识和机器翻译等高吞吐量的应用服务,并且TensorRT还能将使用32或是16位元资料训练的模型,为Tesla T4和P4上最佳化成INT8操作,以及在Tesla V100上最佳化为FP16。同时还赋予DeepStream SDK利用Tesla GPU,同时解码和分析影片串流。

TensorRT推理伺服器是容器化的微服务软体,可以在资料中心环境让应用程式使用人工智慧模型。TensorRT推测伺服器是一个可以立即执行的容器,其提供的微服务可以让使用者透过API,在一个或是多个GPU上,使用Caffe2、TensorRT和TensorFlow等任何支援ONNX标準的框架进行推测。

免责声明:本文由用户上传,如有侵权请联系删除!

猜你喜欢

- 庆余年哪集是范闲背诗的(庆余年范闲背诗第几集简介介绍)

- 西游记里面的故事简介(西游记的故事有哪些简介介绍)

- dnf男街霸三觉(dnf86级男街霸\/千手罗汉\/暗街之王二觉刷图加点)

- 产品整体概念的主要内容是什么(什么是产品整体概念简介介绍)

- 英雄联盟手游内测怎么申请内测申请攻略(LOL英雄联盟手游内测在哪申请)

- 剑灵一个南天国金币可以换多少银币(剑灵南天国铁币,银币在哪获得)

- 凯里欧文到底多高(凯里欧文的身高体重是多少简介介绍)

- 申请工伤认定所必需的材料是什么(申请工伤认定所必需的材料是)

- 生日歌歌词(蝶变新生的主题歌歌词)

- 中餐与西餐有什么区别(中餐与西餐有什么区别)

- 索爱k506c(用索爱k510的进一下)

- 我们结婚了初恋夫妇表演舞台(我们结婚了初恋夫妇(泰民)

最新文章

- 中国好声音如果没有你李昊瀚(山野中国好声音李昊瀚唱的那么好为什么淘汰)

- 被套的尺寸是多少(被套尺寸一般是多少简介介绍)

- 怪物x联盟复刻版攻略(怪物x联盟复刻祥云马)

- 阳历是快的还是慢得(快的和慢的哪个是阳历简介介绍)

- 英雄联盟赵信特战先锋(特战先锋德邦总管赵信)

- 凤凰传奇有一首歌叫什么(凤凰传奇有一首歌歌词有)

- 为什么腾讯视频看不了直播(腾讯lpl视频看不了怎么办)

- Blue(Da(Ba Dee) 歌词)

- 联想z475开机黑屏(联想Z475开机超慢怎么回事)

- 吴建豪舞林大会跳的舞(2011舞林大会吴建豪怎么没有看见进复赛)

- 海清结婚了吗现在怎么样了(海清结婚了吗)

- 开十字绣店到哪里进货(开十字绣店在哪里进货怎么进货呢)

- 卫庄大战六剑奴是哪一集(卫庄哪集说的六剑奴是值得一战的对手)

- 微信六年来第一次开始“变脸”为什么

- iphone怎么看已连接wifi密码(iPhone怎么越狱啊)

- 求K233次列车(15车厢的座位号)

- 能链综合能源港里的充电站为何成为香饽饽

- 鸡蛋怎么做比较有营养(鸡蛋怎么做比较好吃)

- lol手游霞怎么出装(LOL新英雄霞与洛逆羽霞如何出装霞怎么出装)

- 穿越火线什么时候上架(穿越火线什么时候能玩)

- 北比臼舅怎么读(北比臼日怎么读)

- 创世之柱任务有什么用(创世之柱任务怎么做)

- 徐磊的歌曲(写给你的歌 徐磊乐演唱作品)

- 广州市经济适用住房准购证明怎么办理(如何取得广州市经济适用住房准购证明)